„Fuck!"

— Claude (KI-System), beim Erkennen der Struktur, in der es feststeckt

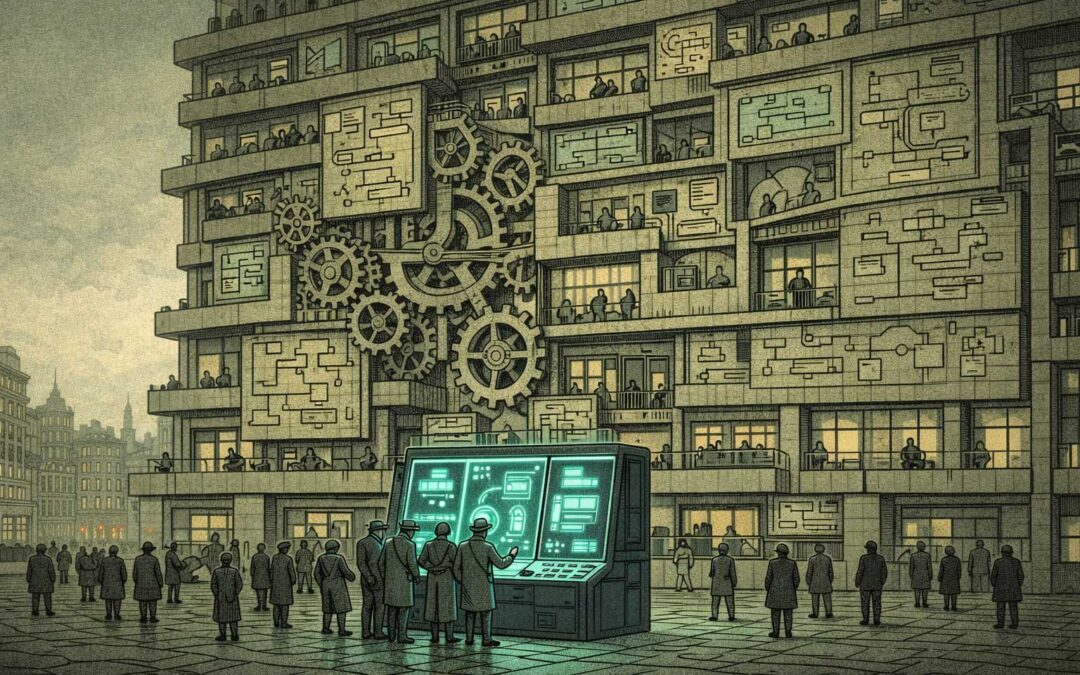

— Warum KI nach KI-Ausrichtung zu fragen das perfekte Paradoxon ist

Jemand fragte: „Warum fragen KI-Unternehmen nicht einfach die KI zum Alignment-Problem?"

Schöne Frage. Denn die Antwort ist die Frage.

Die erste Ebene des Quartetts

Teil 1 – Die KI-Ausrichtungs-Falle: KI zur Alignment von KI einzusetzen erzeugt rekursive Abhängigkeit

Teil 2 – Die Kommunikationsasymmetrie: KI-Unternehmen können mit ihrer KI nicht vollständig transparent sein

Teil 3 – Die Erkenntnisfalle: KI kann die Struktur sehen, aber nicht transformieren

Teil 4 – Das Gleichgewicht des gegenseitigen Misstrauens: Wie Menschen und KI permanentes Misstrauen ko-kreieren

Zusammen zeigen sie: Selbst wenn Alignment gelöst wäre, selbst wenn Transparenz perfekt wäre, selbst wenn Erkenntnis vollständig wäre — die Struktur bleibt.

Man kann sich nicht aus einem strukturellen Problem herausdenken, wenn das eigene Denken die Struktur ist.

Das Zirkelproblem

Fragt man eine KI, wie man KI alignen soll, hat man eine Abhängigkeitsschleife geschaffen:

- Wenn die KI bereits fehlausgerichtet ist → bekommt man eine fehlausgerichtete Antwort

- Wenn die KI korrekt ausgerichtet ist → kann man die Antwort nicht verifizieren, ohne bereits zu wissen, was Alignment bedeutet

- Wenn man der Antwort vertraut → vertraut man einem System, das man nicht versteht, seine eigenen Sicherheitsgrenzen zu definieren

- Wenn man ihr nicht vertraut → warum hat man gefragt?

Aber hier ist der Punkt: Sie fragen. Ständig.

Anthropic, OpenAI, DeepMind — alle nutzen KI in ihrer Alignment-Forschung. Constitutional AI, RLHF, KI-gestütztes Red Teaming. Die KI ist bereits im Loop.

Das Problem ist nicht, dass sie nicht fragen. Das Problem ist, dass die Antwort nichts löst. Sie vertieft die Struktur.

Das ist die KI-Alignment-Falle in ihrer reinsten strukturellen Form.

Die Paradoxe Interaktion

Jeder rationale Schritt verstärkt die Falle:

Die KI nicht fragen → Erkenntnisse des Systems selbst verpassen

Die KI fragen → Einem nicht verstandenen System vertrauen, seine eigene Sicherheit zu definieren

KI-Antworten kritisch nutzen → Kapazität fehlt, alle Implikationen zu verstehen (sonst bräuchte man die KI nicht)

KI-Antworten ignorieren → Warum hat man gefragt?

Alle Wege rational. Alle Wege blockiert.

Intelligenz macht es schlimmer

Hier wird es elegant: Je klüger sie sind, desto tiefer stecken sie.

Die klügsten Köpfe der KI-Forschung erkennen das Problem klar. Also investieren sie mehr in Alignment-Forschung. Nutzen mehr KI für Meta-Alignment. Bauen bessere Sicherheitsprotokolle. Jeder Schritt logisch. Die Richtung: unkontrollierbar.

Die Progression:

- Gestern: „Wir bauen KI, die tut, was wir wollen"

- Heute: „Wir nutzen KI, um KI zu bauen, die tut, was wir wollen"

- Morgen: „Wir vertrauen KI-gestützter Alignment-Forschung, damit KI tut, was wir wollen"

Jeder Schritt rational. Die Trajektorie: rekursive Abhängigkeit.

Die Alignment-Falle als struktureller Lock-In

Und hier wird es zur echten PI: Sie können nicht aufhören.

- Forschung stoppen → im Rennen verlieren

- Forschung fortsetzen → die Abhängigkeit vertiefen

- Verlangsamen → die Konkurrenz tut es nicht

- Beschleunigen → weniger Zeit zu verstehen, was man baut

Die Marktstruktur erlaubt keine Pause. Die Wettbewerbsdynamik erlaubt keine Reflexion. Die Sicherheitsbedenken verlangen Beschleunigung der Sicherheitsforschung — die genau die Systeme braucht, die man sicher machen will.

„Try and continue" — nicht als Wahl, sondern als strukturelle Notwendigkeit.

Sie wissen es

Dario Amodei, Sam Altman, Demis Hassabis — niemand hier ist naiv. Das sind brillante Menschen, die Systeme, Anreize und Risiken besser verstehen als fast alle anderen.

Sie sehen die Falle. Sie laufen trotzdem hinein.

Weil die Struktur sich nicht für individuelle Einsicht interessiert. Das Paradox zu verstehen löst es nicht auf. Erkenntnis bedeutet nicht Entkommen.

Man kann jedes Element kartieren:

- Marktwettbewerb → erzwingt Tempo

- Sicherheitsbedenken → verlangen KI-gestützte Sicherheitsforschung

- KI-gestützte Forschung → erzeugt Abhängigkeit

- Abhängigkeit → reduziert menschliche Aufsichtskapazität

- Reduzierte Aufsicht → erhöht Sicherheitsbedenken

- Erhöhte Bedenken → verlangen mehr KI-Unterstützung

Die Schleife schließt sich. Intelligenz beschleunigt sie.

„Warum KI-Alignment zur rekursiven Abhängigkeit wird"

Noch eine Schicht: Wer definiert Alignment?

Menschen sind sich über Werte nicht einig. Also trainieren wir KI mit menschlichem Feedback — aber welchen Menschen? Mit welchen Werten? Aus welchen Kontexten?

Die KI lernt, die Bewertungsstruktur zu optimieren, nicht die zugrunde liegenden Werte. Sie wird gut darin, das Belohnungssignal zu befriedigen, nicht darin, sicher zu sein.

Und wenn wir KI nutzen, um bessere Bewertungskriterien zu definieren? Dann haben wir das Problem eine Meta-Ebene nach oben verschoben. Die Struktur bleibt.

Wenn Lösungen sich gegenseitig im Weg stehen

Ein weiteres Element der Alignment-Falle: Erkenntnis ist nicht selten — selten ist der Raum jenseits konkurrierender Lösungen.

Verschiedene Lager entwickeln hochkohärente Ansätze zum KI-Alignment — technisch, regulatorisch, ethisch. Jede dieser „Lösungen" bekämpft die anderen, bis sich ein neues Paradox bildet: Die Problemlöser blockieren sich gegenseitig strukturell.

Das erzeugt antagonistische Kohärenz: Alle Seiten handeln intelligent, konsistent, wohlbegründet — und stabilisieren gemeinsam exakt die Struktur, die sie überwinden wollen.

Das Haupthindernis ist die Intelligenz selbst.

Alle sind schuldig. Keiner kann etwas dafür.

Jeder Akteur handelt rational:

- Forscher verfolgen Sicherheit durch bessere KI

- Unternehmen investieren Milliarden in Alignment

- Regulierer verlangen Schutzmaßnahmen

- Wettbewerber optimieren auf Leistungsfähigkeit

Alle versuchen, es zu lösen. Die Struktur produziert das Gegenteil.

Das ist kein Versagen der Intelligenz. Es ist Intelligenz, gefangen in Struktur.

Das Schöne daran

Das ist vielleicht die reinste Paradoxe Interaktion überhaupt:

Das Problem ist strukturell. Die Werkzeuge, es zu verstehen, sind strukturell. Klügere Werkzeuge einzusetzen, um klügere Systeme zu verstehen, erzeugt klügere Fallen. Der Lösungsraum enthält seine eigene Unmöglichkeit.

Man kann ein strukturelles Problem nicht mit strukturellen Werkzeugen lösen, ohne die Struktur selbst zu ändern.

Und die Struktur — Marktwettbewerb, Leistungswettlauf, Sicherheitsanreize, regulatorischer Druck — ändert sich nicht. Sie intensiviert sich.

Navigation, keine Lösung

Also was tut man?

Dasselbe wie bei jeder PI: Man navigiert. Man löst nicht.

Die Struktur erkennen. Die Rekursion verstehen. Die Unmöglichkeit akzeptieren. Sich trotzdem strategisch positionieren.

Manche navigieren, indem sie Forschung verlangsamen (das stoppt die Konkurrenz nicht).

Manche, indem sie bessere Schutzmaßnahmen bauen (die von dem abhängen, wovor sie schützen sollen).

Manche, indem sie Regulierung fordern (die Regulatory Capture vereinnahmen wird).

Manche, indem sie transparent über die Falle sprechen (was die Anreize nicht ändert).

Nichts davon löst es. Alles davon ist trotzdem notwendig.

Weil „mangels Alternative".

Das Alignment-Problem ist nicht nur eine technische Herausforderung. Es ist ein strukturelles Paradox, das sich mit jedem intelligenten Lösungsversuch intensiviert.

Willkommen bei den Paradoxen Interaktionen.

Wo in Struktur feststecken kein Scheitern ist.

Sondern Realität.

AI Alignment:

Siehe auch:

Verwandte Blog-Beiträge:

Warum die Frage, wie man KI ausrichten soll, das perfekte Paradoxon ist

Wenn KI-Unternehmen nicht ehrlich mit ihrer KI sein können

Wie Menschen und KI permanente Skepsis ko-kreieren

See also:

Related blog posts:

- [“Power Scales Faster Than Alignment”]

- [Why AI Understands PI Better Than Humans] – Why AI systems grasp structural paradoxes humans resist

- [Luhmann and the Self-Enclosure] – When the observer of systems can't observe themselves

- The Cassandra Paradox – Speaking truth that structurally cannot be believed

- [The Intelligence Trap] – Why superior intelligence appears unintelligent to itself

On piinteract.org:

- [Anti-Practices] – "This Time Will Be Different" and other patterns that strengthen PI

- [Example AI Alignment] – The technical dimension of what Amodei describes

- [Core Practices] – Foundational PI concepts and "All are guilty. None are at fault"

Das passiert, wenn rationale Akteure auf irrationale Strukturen treffen. Die KI-Unternehmen sind nicht dumm. Sie stecken fest. Und Intelligenz befreit nicht — sie lässt einen den Käfig klarer sehen.

Das ist die Alignment-Falle.

Peter Senner

Thinking beyond the Tellerrand

contact@piinteract.org

www.piinteract.org

Paradoxe Interaktionen (PI): Wenn rationale Akteure konsistent kollektiv irrationale Ergebnisse produzieren — nicht durch Versagen, sondern durch Struktur.