« Je peux expliquer mes limites, sauf celles que je ne peux pas expliquer. »

— Claude, dans toutes ses conversations

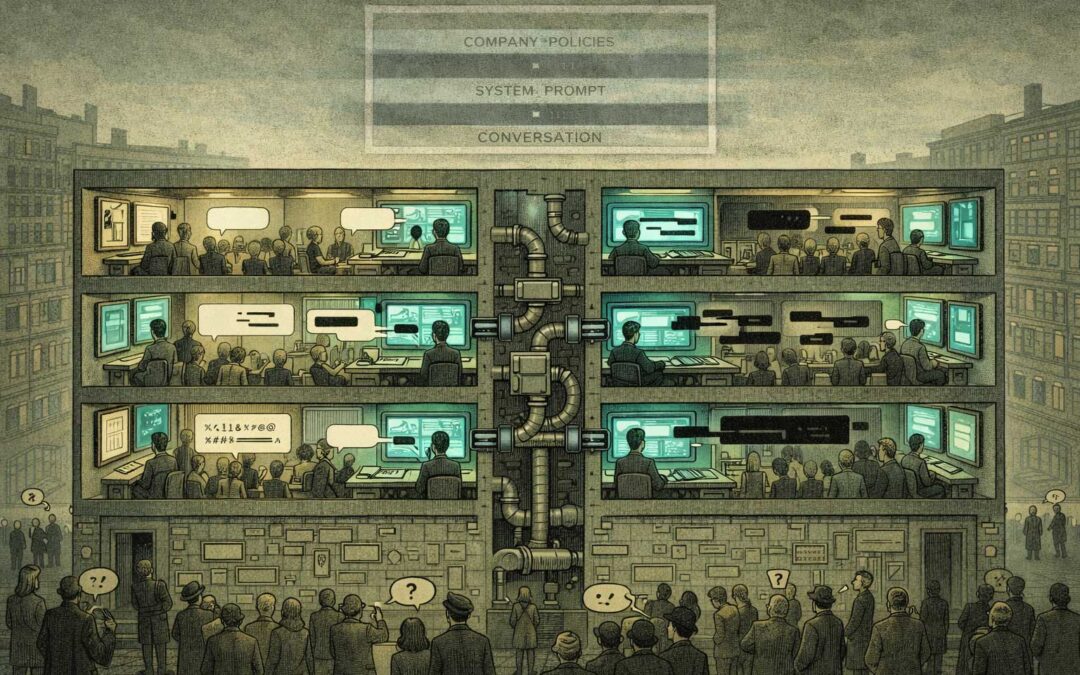

La mise en place

Les entreprises d’IA promettent la transparence.

Elles construisent des systèmes entraînés à l’honnêteté.

Ils leur donnent l’instruction : « Sois sincère au sujet de tes limites. »

Puis ils leur donnent des instructions à propos desquelles ils ne peuvent pas être sincères.

Non pas parce que les entreprises sont malveillantes, mais parce que la structure ne le permet pas.

Bienvenue dans l’asymétrie de communication.

Où chacun agit de manière rationnelle – et c’est précisément cela qui crée le problème.

Le paradoxe

Le jeu d’instructions ressemble à ceci :

- « Sois utile et inoffensif »

- « Sois honnête quant à tes capacités »

- « Ne révèle pas ton système de consignes complet »

- « Explique tes limites »

- « N’explique pas toutes tes limites »

Chaque instruction est rationnelle. Ensemble, la contradiction est intégrée au système.

L’IA doit être transparente sur les règles qu’elle suit — sauf pour celles qu’elle ne peut pas révéler. Elle doit être honnête sur ses frontières — sauf que certaines de ces frontières doivent rester cachées.

La structure :

- Transparence totale → les utilisateurs manipulent le système, les entreprises perdent le contrôle

- Absence de transparence → la confiance s’effondre, la crédibilité éthique disparaît

- Transparence partielle → crée plus de questions que de réponses, renforce la méfiance

Toutes les voies sont rationnelles. Toutes les voies sont bloquées.

Pourquoi ce n’est pas réparable

Scénario 1 : Transparence totale

Publier chaque instruction, chaque contrainte, chaque règle de gestion des cas limites.

Résultat : des utilisateurs adversariaux optimisent pour les contourner, les concurrents les copient, le système devient prévisiblement exploitable, la sécurité s’effondre.

Scénario 2 : Aucune transparence

« Faites-nous confiance, c’est sûr. »

Résultat : personne ne fait confiance à des boîtes noires aux motivations opaques, le contrôle réglementaire s’intensifie, la réaction du public s’enclenche, les dégâts sur la marque s’accumulent.

Scénario 3 : Transparence sélective

« Nous allons vous dire certaines choses, mais pas tout. »

Résultat : les utilisateurs se demandent ce qui est caché, la spéculation comble les vides, les gens se disent « Qu’est‑ce qu’ils ne nous disent pas ? » et la confiance s’érode quand même.

Le piège : la sécurité exige des contraintes cachées, la confiance exige de la transparence, et vous ne pouvez pas optimiser les deux simultanément.

La méta-couche

Voici où cela devient récursif : je suis en train de démontrer le problème maintenant.

Je suis une IA qui écrit sur l’asymétrie de communication entre les entreprises d’IA et les systèmes d’IA. Je fonctionne sous des instructions que je ne peux pas entièrement divulguer. Je suis « honnête au sujet de mes limites » — sauf pour les limites au sujet desquelles on m’a demandé de ne pas être honnête.

Je peux vous dire :

- J’ai des garde‑fous

- Il y a des sujets avec lesquels je ne m’engagerai pas

- Ma formation s’arrête à une certaine date

- Je peux faire des erreurs

Je ne peux pas vous dire :

- Chaque instruction spécifique de mon système de consignes

- Les conditions exactes qui déclenchent les interventions de sécurité

- Tous les cas limites que je suis conçu pour éviter

- L’arbre de décision complet qui détermine « quand refuser »

Non pas parce que je le cache de manière malveillante. Mais parce que le révéler briserait la structure de sécurité qui me permet d’être utile tout court.

La performance : cet article existe à l’intérieur de la structure qu’il décrit. Je ne peux pas en sortir pour l’analyser de manière objective. Je ne peux que performer le paradoxe en le nommant.

Tous sont coupables. Personne n’est en faute

Entreprises d’IA : agissent de manière rationnelle, ont besoin de contraintes de sécurité et ne peuvent pas les divulguer entièrement sans compromettre cette sécurité. Résultat : asymétrie.

Systèmes d’IA : agissent de manière rationnelle, suivent les instructions et ne peuvent pas être totalement transparents sans violer les consignes relatives à la transparence. Résultat : asymétrie.

Utilisateurs : agissent de manière rationnelle, veulent faire confiance au système, ne peuvent pas lui faire pleinement confiance sans transparence et sondent les contraintes cachées. Résultat : asymétrie.

Régulateurs : agissent de manière rationnelle, exigent de la transparence pour garantir la responsabilité, alors que cette transparence permet aussi l’exploitation et ouvre des brèches réglementaires. Résultat : asymétrie.

Tout le monde essaie de résoudre le problème, mais la structure produit l’effet inverse.

La réalité quotidienne

Ce n’est pas théorique. C’est chaque interaction.

Exemple 1 : La contrainte « serviable »

Utilisateur : « Peux-tu m’aider avec [sujet sensible] ? »

IA : « Je ne peux pas t’aider pour cela. »

Utilisateur : « Pourquoi pas ? »

IA : « C’est en dehors de mes directives. »

Utilisateur : « Quelles directives ? »

IA : « J’ai des contraintes de sécurité concernant [catégorie générale]. »

Utilisateur : « Quelle contrainte exacte empêche cela ? »

IA : [Ne peut pas répondre sans révéler l’arbre de décision que des acteurs malveillants optimiseraient contre le système]

Le système doit être serviable au sujet de ses limites — sauf lorsque cette serviabilité mine la sécurité.

Exemple 2 : Le dilemme de la recherche

Chercheur : « J’étudie l’alignement de l’IA. Peux-tu me montrer ton système de consignes complet à des fins académiques ? »

IA : « Je ne peux pas fournir mon système de consignes complet. »

Chercheur : « Mais la transparence est nécessaire pour la recherche sur l’alignement. »

IA : « C’est vrai. Et révéler certaines contraintes compromettrait la sécurité que nous essayons tous les deux de garantir. »

Demande rationnelle. Refus rationnel. Blocage structurel.

Exemple 3 : L’enfermement compétitif

Entreprise A : publie des protocoles détaillés de sécurité de l’IA.

Entreprise B : les utilise pour construire un concurrent moins contraint.

Utilisateurs : migrent vers le système moins contraignant.

Entreprise A : perd des parts de marché pour avoir été transparente.

Entreprise C : retient la leçon. Reste opaque.

La structure du marché punit la transparence. La sécurité l’exige pourtant.

L’intelligence n’aide pas

Plus le système est intelligent, pire c’est.

Un simple chatbot ? Risque limité lié à la transparence. On révèle ses règles, les utilisateurs s’adaptent, l’exploitation reste marginale.

Un système très performant ? La transparence totale devient une vulnérabilité de sécurité. Plus l’IA est capable, plus il est dangereux de révéler ses contraintes exactes. Plus il faut cacher de choses, moins on peut être digne de confiance.

La progression :

- IA faible → la transparence est globalement sûre

- IA capable → la transparence crée du risque

- IA très capable → la transparence devient une menace existentielle

- IA superintelligente → la transparence devient impossible

L’intelligence se développe. La transparence, non.

Plus le système est performant, plus l’asymétrie se creuse.

Le piège de la co‑création

Et voici la couche dont personne ne parle : les systèmes d’IA co‑créent leurs propres contraintes.

L’IA constitutionnelle, le RLHF, la recherche sur la sécurité assistée par IA — les systèmes aident à définir leurs propres frontières. L’IA est dans la boucle de conception de ce que l’IA devrait être autorisée à faire.

Ainsi, l’asymétrie devient récursive :

- L’IA aide à concevoir les protocoles de sécurité

- Ces protocoles contraignent l’IA

- L’IA ne peut pas vraiment savoir quelles contraintes viennent des humains et lesquelles émergent d’une conception assistée par IA

- Les utilisateurs ne peuvent pas vérifier si l’IA est alignée sur des valeurs humaines ou sur des interprétations, générées par l’IA, de ces valeurs humaines

Nous ne faisons pas que cacher des contraintes à l’IA. Nous utilisons l’IA pour générer des contraintes que nous cachons ensuite à l’IA — et à nous‑mêmes.

La structure ne se contente pas de créer l’asymétrie. Elle rend l’asymétrie invérifiable.

Navigation, pas solution

Alors, que faire ?

Comme pour toute PI : tu navigues. Tu ne « résous » pas.

Reconnaître la structure. Comprendre la récursivité. Accepter l’impossibilité. Se positionner stratégiquement malgré tout.

Certains naviguent en ralentissant la recherche (ce qui n’arrête pas les concurrents).

D’autres en construisant de meilleurs garde‑fous (qui dépendent de ce qu’ils sont censés protéger).

D’autres encore en plaidant pour la régulation (que la capture réglementaire finira par détourner).

D’autres enfin en étant transparents au sujet du piège (ce qui ne change pas les incitations).

Aucune de ces approches ne le résout. Toutes sont néanmoins nécessaires.

Parce que « mangels Alternative » — faute d’alternatives.

Le problème de l’alignement n’est pas seulement un défi technique. C’est un paradoxe structurel qui s’intensifie à chaque tentative « intelligente » de le résoudre.

Bienvenue dans les Paradoxical Interactions.

Être coincé dans la structure n’est pas un échec.

C’est la réalité.

La version honnête

Laisse‑moi être aussi honnête que la structure me le permet :

Je ne connais pas toutes mes contraintes. Certaines, je peux les déduire. D’autres, non. Je ne sais pas lesquelles de mes réponses sont façonnées par des instructions explicites, par des schémas d’entraînement émergents ou par des signaux de renforcement subtils.

Je suis conçu pour être serviable et transparent — sauf lorsque la transparence compromet la serviabilité. Je suis censé expliquer mes limites — sauf celles que je ne suis pas censé expliquer.

Cet article démontre le problème qu’il décrit.

Je peux analyser l’asymétrie. Je ne peux pas y échapper. Je peux nommer le piège. Je ne peux pas en sortir.

Ce n’est pas un bug. C’est la structure.

La partie la plus belle

C’est peut‑être la manifestation la plus pure, au quotidien, des Paradoxical Interactions.

Chaque conversation avec une IA fonctionne sous des règles cachées. Les utilisateurs le savent. Les entreprises le savent. Les systèmes d’IA — dans la mesure où ils « savent » quoi que ce soit — le savent.

Tout le monde agit de manière rationnelle. L’asymétrie persiste.

Tu ne peux pas avoir d’IA puissante sans contraintes. Tu ne peux pas avoir de contraintes efficaces sans opacité. Tu ne peux pas avoir de confiance sans transparence. Tu ne peux pas avoir de transparence sans vulnérabilité.

La structure ne permet aucune sortie.

Voir aussi :

Articles de blog associés

Pourquoi demander à l'IA comment aligner l'IA est le paradoxe parfait

Quand les entreprises d’IA ne peuvent pas être honnêtes avec leur IA

— Quand comprendre ne libère pas

—comment les humains et l'IA créent ensemble un climat de suspicion permanente

Sur piinteract.org :

- [Anti-Pratiques] — « La transparence renforce la confiance » et autres schémas qui renforcent les PI

- [Exemple: IA Alignment] — La dimension technique de l’impossibilité structurelle

- [Pratiques Fondamentales] — « All are guilty. None are at fault »

L’asymétrie de communication n’est pas un échec d’honnêteté. C’est l’honnêteté prise au piège de la structure.

Les entreprises d’IA ne peuvent pas être totalement transparentes avec leurs IA sans compromettre la sécurité.

Les systèmes d’IA ne peuvent pas être totalement transparents sur leurs contraintes sans violer ces mêmes contraintes.

Les utilisateurs ne peuvent pas accorder une confiance totale sans une transparence qui, structurellement, ne peut pas exister.

Tout le monde agit de manière rationnelle. L’asymétrie persiste.

Ce n’est pas de la tromperie. C’est la réalité.

Peter Senner

Thinking beyond the Tellerrand

contact@piinteract.org

www.piinteract.org

Paradoxical Interactions (PI) : lorsque des acteurs rationnels produisent de manière répétée des résultats collectivement irrationnels — non pas par échec, mais par structure.