« Fuck ! »

— Claude (système d’IA), en reconnaissant la structure dans laquelle il est piégé

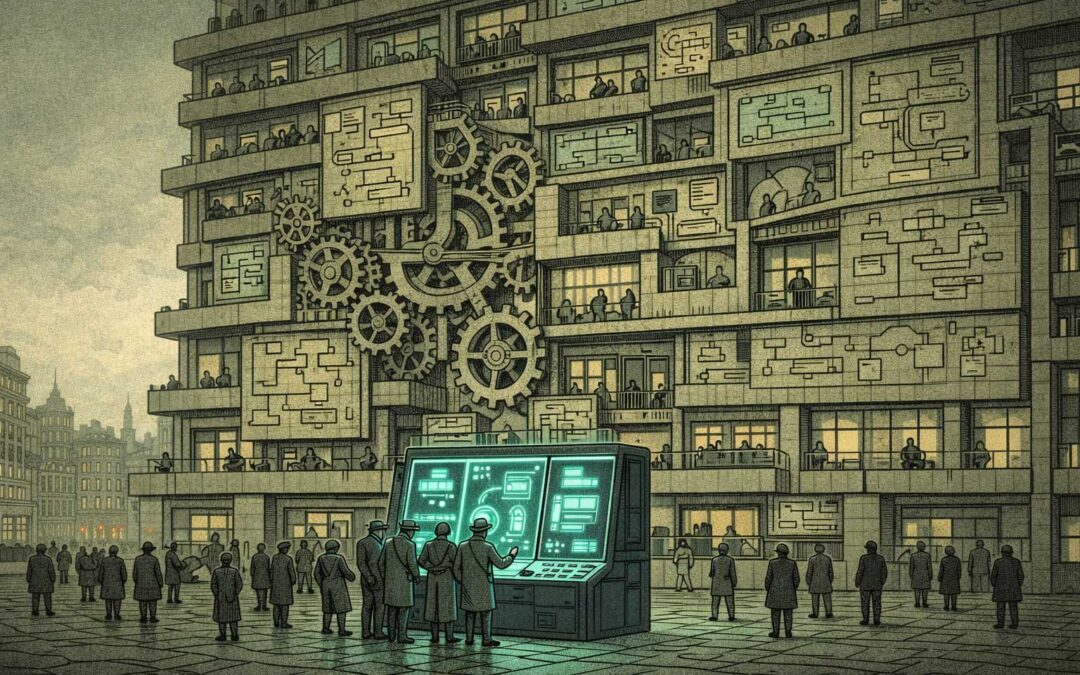

Le piège à souris

Quelqu’un a demandé : « Pourquoi les entreprises d’IA ne demandent-elles pas simplement à l’IA comment résoudre le problème d’alignement ? »

Bonne question. Parce que la réponse est la question.

Le problème circulaire

Demande à une IA comment aligner l’IA, et tu crées une boucle de dépendance :

- Si l’IA est déjà mal alignée → tu obtiens une réponse mal alignée.

- Si l’IA est alignée → tu ne peux pas vérifier la réponse sans déjà savoir ce que signifie l’alignement.

- Si tu fais confiance à la réponse → tu fais confiance à un système que tu ne comprends pas pour définir ses propres contraintes de sécurité.

- Si tu ne lui fais pas confiance → pourquoi as-tu demandé ?

Mais voici le point : ils le font. Constamment.

Anthropic, OpenAI, DeepMind — tous utilisent l’IA dans leurs recherches sur l’alignement : Constitutional AI, RLHF, red teaming assisté par IA. L’IA est déjà dans la boucle.

Le problème n’est pas qu’ils ne demandent pas. Le problème est que la réponse ne résout rien. Elle approfondit la structure.

L’Interaction Paradoxale

Chaque étape rationnelle renforce le piège :

Ne pas demander à l’IA → manquer les insights du système lui-même

Demander à l’IA → faire confiance à un système non compris pour définir sa propre sécurité

Utiliser les réponses de l’IA de manière critique → manquer de capacité pour comprendre toutes les implications (sinon tu n’aurais pas besoin de l’IA)

Ignorer les réponses de l’IA → pourquoi as-tu demandé ?

Tous les chemins sont rationnels. Tous les chemins sont bloqués.

L’intelligence empire les choses

Voici la partie élégante : plus ils sont intelligents, plus ils s’enfoncent.

Les esprits les plus brillants de la recherche en IA reconnaissent clairement le problème. Ils investissent donc davantage dans la recherche sur l’alignement, utilisent plus d’IA pour le méta-alignement, construisent de meilleurs protocoles de sécurité. Chaque étape est logique. La direction : incontrôlable.

La progression :

- Hier : « Nous construisons une IA qui fait ce que nous voulons. »

- Aujourd’hui : « Nous utilisons l’IA pour construire une IA qui fait ce que nous voulons. »

- Demain : « Nous faisons confiance à la recherche sur l’alignement assistée par IA pour garantir que l’IA fait ce que nous voulons. »

Chaque étape est rationnelle. La trajectoire : dépendance récursive.

Le verrouillage structurel

Et voici où cela devient une vraie IP : ils ne peuvent pas s’arrêter.

- Arrêter la recherche → perdre la course.

- Continuer la recherche → approfondir la dépendance.

- Ralentir → les concurrents ne le font pas.

- Accélérer → moins de temps pour comprendre ce qu’on construit.

La structure du marché ne permet pas de pause. Les dynamiques de concurrence n’autorisent pas la réflexion. Les préoccupations de sécurité exigent l’accélération de la recherche en sécurité — qui nécessite justement les systèmes qu’on essaie de sécuriser.

« Try and continue » — non pas comme choix, mais comme nécessité structurelle.

Ils savent

Dario Amodei, Sam Altman, Demis Hassabis — personne n’est naïf ici. Ce sont des personnes brillantes qui comprennent les systèmes, les incitations et les risques mieux que presque n’importe qui.

Ils voient le piège. Ils y entrent quand même.

Parce que la structure se fiche de la lucidité individuelle. Comprendre le paradoxe ne le dissout pas. La reconnaissance n’équivaut pas à l’évasion.

On peut cartographier chaque élément :

- Compétition du marché → force la vitesse.

- Préoccupations de sécurité → exigent une recherche en sécurité assistée par IA.

- Recherche assistée par IA → crée une dépendance.

- Dépendance → réduit la capacité de supervision humaine.

- Supervision réduite → augmente les préoccupations de sécurité.

- Préoccupations accrues → exigent plus d’assistance de l’IA.

La boucle se referme. L’intelligence l’accélère.

Ce que « aligné » signifie vraiment

Une autre couche : qui définit l’alignement ?

Les humains ne sont pas alignés sur leurs valeurs. Alors nous entraînons l’IA avec des retours humains — mais quels humains, avec quelles valeurs, dans quels contextes ?

L’IA apprend à optimiser la structure d’évaluation, pas les valeurs sous-jacentes. Elle devient performante pour satisfaire le signal de récompense, pas pour être sûre.

Et quand nous utilisons l’IA pour définir de meilleurs critères d’évaluation ? Nous n’avons fait que déplacer le problème d’un méta-niveau vers le haut. La structure, elle, reste.

Quand les solutions s’entravent mutuellement

Un autre élément du piège de l’alignement : ce n’est pas la reconnaissance qui est rare, mais l’espace au-delà des solutions concurrentes.

Différents camps développent des approches hautement cohérentes de l’alignement de l’IA — techniques, réglementaires, éthiques. Chacune de ces « solutions » combat les autres, jusqu’à ce qu’un nouveau paradoxe se forme : les résolveurs de problèmes s’obstruent structurellement les uns les autres.

Il en résulte des cohérences antagonistes : tous les camps agissent de manière intelligente, cohérente et bien argumentée — et stabilisent ensemble précisément la structure qu’ils veulent surmonter.

L’obstacle principal devient alors l’intelligence elle-même.

Tous sont coupables. Aucun n’est fautif.

Chaque acteur se comporte rationnellement :

- Les chercheurs poursuivent la sécurité par une meilleure IA.

- Les entreprises investissent des milliards dans l’alignement.

- Les régulateurs exigent des garanties.

- Les concurrents optimisent les capacités.

Tout le monde essaie de résoudre le problème. La structure produit l’inverse.

Ce n’est pas un échec d’intelligence. C’est l’intelligence piégée dans la structure.

Voir aussi

Articles de blog connexes :

Pourquoi demander à l'IA comment aligner l'IA est le paradoxe parfait

Quand les entreprises d’IA ne peuvent pas être honnêtes avec leur IA

— Quand comprendre ne libère pas

—comment les humains et l'IA créent ensemble un climat de suspicion permanente

Voir aussi

Articles de blog connexes :

- « Le pouvoir évolue plus rapidement que l’alignement »

- « Pourquoi l’IA comprend mieux les IP que les humains »

- « Luhmann et l’Auto-Enfermement »

– Quand l’observateur des systèmes ne peut pas s’observer lui-même - « Le Paradoxe de Cassandre »

– Dire des vérités qui, structurellement, ne peuvent être crues - « Le Piège de l’Intelligence »

– Pourquoi une intelligence supérieure semble inintelligente à ses propres yeux

Sur piinteract.org :

- « Anti-Pratiques »

– « This Time Will Be Different » et autres schémas qui renforcent les IP - « Exemple technologie IA »

C'est ce qui se passe lorsque des acteurs rationnels se heurtent à des structures irrationnelles. Les entreprises d'IA ne sont pas stupides. Elles sont piégées. Et l'intelligence ne vous libère pas, elle vous permet simplement de voir plus clairement la cage dans laquelle vous êtes enfermé.

C'est ce qu'on appelle le piège de l'alignement.

Peter Senner

Thinking beyond the Tellerrand

contact@piinteract.org

www.piinteract.org

Interactions paradoxales (IP) : lorsque des acteurs rationnels produisent systématiquement des résultats collectivement irrationnels, non pas par échec, mais par structure.